2026년 1월 CES(Consumer Electronics Show)에서 엔비디아는 차세대 AI 컴퓨팅의 핵심이 될 ‘루빈(Rubin)’ 칩 아키텍처를 공식 발표했다.

2026년 1월 CES(Consumer Electronics Show)에서 엔비디아는 차세대 AI 컴퓨팅의 핵심이 될 ‘루빈(Rubin)’ 칩 아키텍처를 공식 발표했다.

엔비디아 CEO 젠슨 황은 루빈을 “현존 최고 수준의 AI 하드웨어”라고 소개하며, 이미 양산 단계에 돌입했다고 밝혔다.

루빈 아키텍처는 폭발적으로 증가하는 AI 연산 수요를 해결하기 위한 핵심 기술로, 2025년 하반기부터 본격적인 공급 확대가 예정돼 있다.

루빈(Rubin) 아키텍처란 무엇인가?

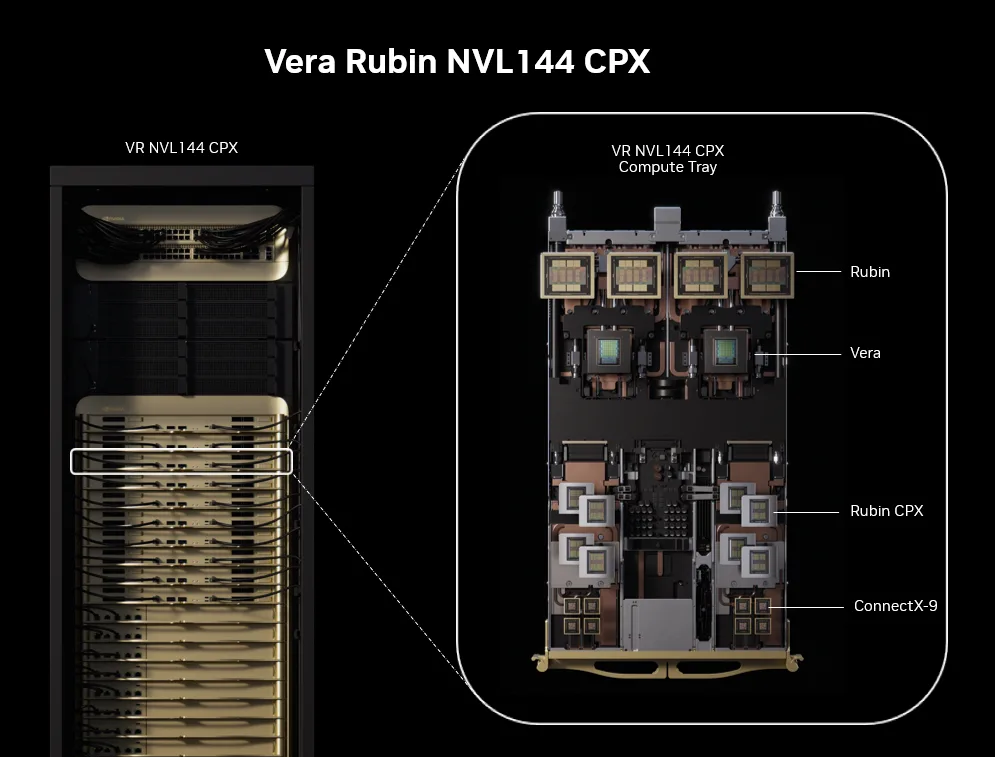

루빈은 단일 GPU가 아니라, 6개의 핵심 칩이 유기적으로 작동하는 통합 AI 플랫폼이다.

대규모 학습·추론·장기 사고(long reasoning)를 전제로 설계된 것이 특징이다.

핵심 구성 요소는 다음과 같다.

-

차세대 루빈 GPU

대규모 AI 모델 학습 및 추론을 담당하는 메인 연산 장치 -

Vera CPU

에이전트형 AI, 장기 추론 워크로드에 최적화된 전용 CPU -

차세대 NVLink 인터커넥트

칩 간 초고속 통신을 지원해 대규모 병렬 연산 효율 극대화 -

BlueField 기반 네트워크·스토리지 개선

데이터 이동 병목 최소화 -

외부 확장형 스토리지 계층

최신 대형 모델에서 문제로 지적된 KV 캐시 메모리 병목을 해결

특히 KV 캐시 부담을 분산하기 위한 새로운 스토리지 계층 도입은, 초거대 언어 모델과 장기 추론 모델을 염두에 둔 설계라는 점에서 주목된다.

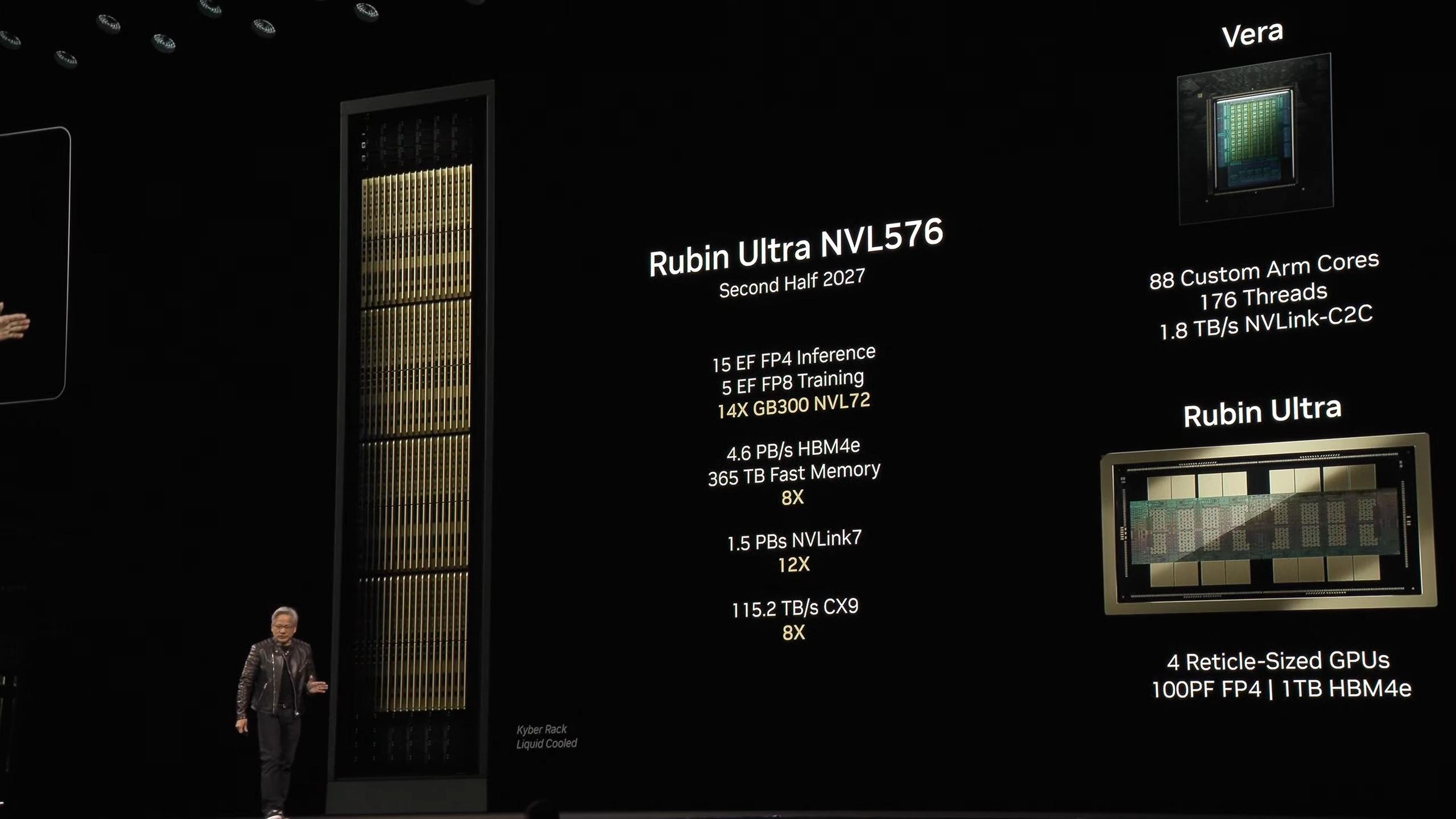

이전 세대 대비 얼마나 강력해졌나?

엔비디아에 따르면 루빈 아키텍처는 이전 세대인 블랙웰(Blackwell) 대비 전방위적인 성능 향상을 이뤘다.

- AI 학습 성능: 최대 3.5배 향상

- 추론(Inference) 성능: 최대 5배 향상

- 연산 성능: 최대 50 PFLOPS

- 전력 효율: 와트당 추론 성능 8배 증가

이는 단순한 속도 개선을 넘어,

- 데이터센터 전력 소비 감소

- 운영 비용 절감

- 동일 전력 대비 더 많은 AI 모델 처리

가 가능해졌음을 의미한다.

글로벌 클라우드와 슈퍼컴퓨터에 적용

루빈 아키텍처는 이미 주요 글로벌 인프라에 채택될 예정이다.

- 주요 글로벌 클라우드 사업자 및 AI 연구 기관

- HPE의 차세대 슈퍼컴퓨터 블루 라이언

- 로렌스 버클리 국립연구소의 차세대 두드나(Doudna) 슈퍼컴퓨터

이에 따라 루빈은

- AI 학습

- AI 추론

- 과학 계산

- 고성능 컴퓨팅(HPC)

전반에서 차세대 표준 인프라로 자리 잡을 가능성이 크다.

AI 인프라 경쟁의 중심에 선 엔비디아

젠슨 황 CEO는 앞서 실적 발표에서

향후 5년간 AI 인프라에 3~4조 달러 규모의 투자가 이뤄질 것이라고 전망한 바 있다.

루빈 아키텍처는 이 거대한 투자 흐름 속에서

- 엔비디아의 AI 하드웨어 주도권 유지

- 경쟁사와의 기술 격차 확대

- 장기 추론·에이전트형 AI 시대 대응

을 위한 핵심 무기로 평가된다.

루빈은 ‘칩’이 아니라 AI 시대의 기반

AI 모델은

- 더 커지고

- 더 오래 사고하며

- 더 복잡한 작업을 수행하는 방향으로 진화 중이다.

이런 흐름 속에서 루빈은 단순한 차세대 GPU가 아니라,

차세대 AI 컴퓨팅 시대를 떠받치는 기반 아키텍처에 가깝다.

엔비디아가 왜 여전히 AI 인프라 경쟁의 중심에 있는지를 보여주는 상징적인 발표라 할 수 있다.